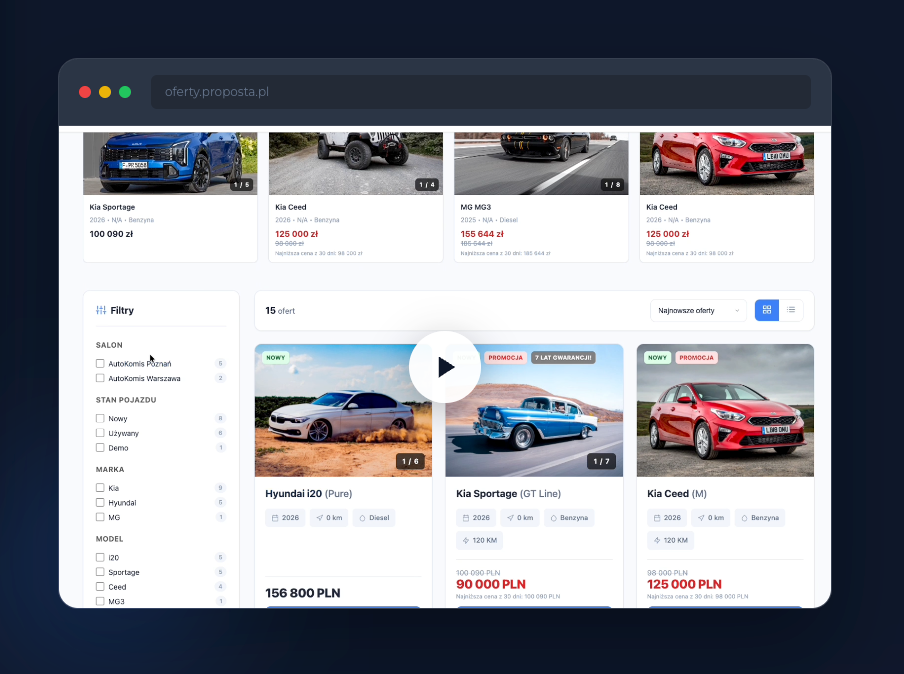

Claude Code to jeden z najciekawszych agentów kodujących dostępnych obecnie na rynku. Standardowo jego używanie wiąże się z abonamentem lub kosztami API Anthropic. Dzięki oficjalnej integracji z Ollamą możliwe jest jednak uruchomienie Claude Code z lokalnym modelem językowym, bez ponoszenia kosztów. Ten artykuł pokazuje, jak zrobić to krok po kroku i kiedy takie rozwiązanie faktycznie ma sens.

Czym jest integracja Ollama z Claude Code

Integracja Ollama z Claude Code pozwala zachować sposób pracy znany z wersji chmurowej, ale zamiast modeli Anthropic wykorzystać lokalnie uruchomiony model LLM. Odpowiedzi generowane są bezpośrednio na Twoim komputerze, co oznacza brak opłat za zapytania i większą kontrolę nad kodem oraz danymi.

Jak działa Claude Code z lokalnym modelem

Claude Code analizuje pliki projektu, kontekst i polecenia użytkownika w taki sam sposób jak przy korzystaniu z API Anthropic. Różnica polega na źródle odpowiedzi. Zamiast modeli chmurowych wykorzystywany jest model dostępny lokalnie w Ollamie, co wpływa na jakość odpowiedzi, ale eliminuje koszty.

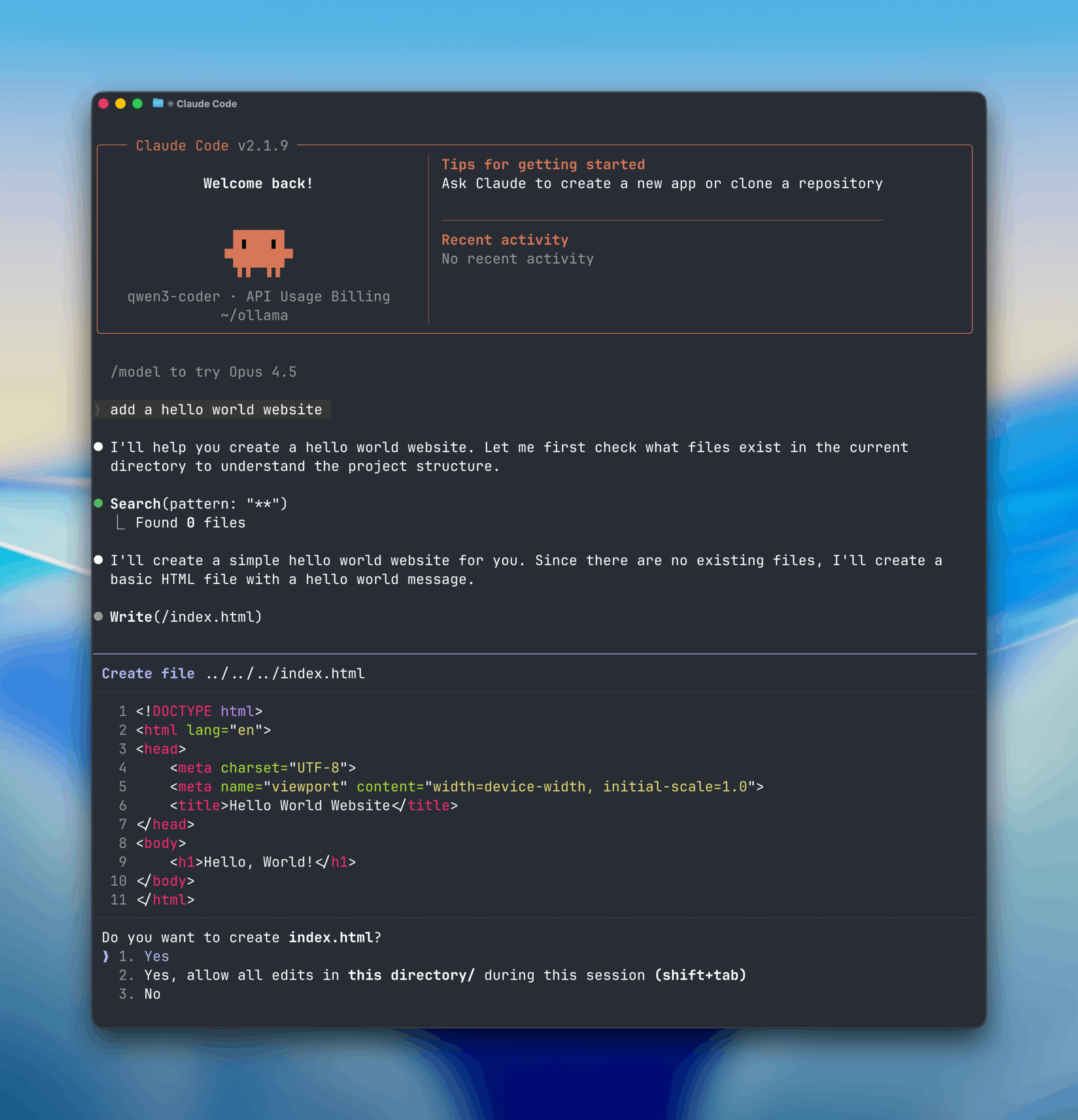

Krok po kroku: jak uruchomić Claude Code z Ollamą

Poniżej znajduje się lista działań, które należy wykonać, aby uruchomić Claude Code w wersji lokalnej. To kompletna checklista, którą można przejść punkt po punkcie.

- Zainstaluj Ollamę na swoim komputerze w systemie macOS, Windows lub Linux.

- Uruchom Ollamę i upewnij się, że działa poprawnie jako lokalny serwer modeli.

- Pobierz lokalny model językowy przeznaczony do kodowania, na przykład qwen3-coder lub gpt-oss:20b.

- Zainstaluj najnowszą wersję Claude Code obsługującą integrację z Ollamą.

- W ustawieniach Claude Code zmień źródło modelu z API Anthropic na lokalną Ollamę.

- Wybierz pobrany model lokalny jako domyślny model do generowania kodu.

- Uruchom Claude Code na przykładowym projekcie i wykonaj pierwsze testy.

Po wykonaniu powyższych kroków Claude Code będzie działał lokalnie i nie będzie wymagał opłacania abonamentu ani korzystania z zewnętrznego API.

Jakie modele lokalne sprawdzą się najlepiej

Do pracy z kodem najlepiej sprawdzają się modele trenowane stricte pod zadania programistyczne. Najczęściej polecane są qwen3-coder oraz gpt-oss w wersji 20b. Oferują one rozsądną jakość przy umiarkowanych wymaganiach sprzętowych, choć nadal ustępują topowym modelom chmurowym.

Jakość lokalnych modeli a Claude Opus

Lokalne modele dobrze radzą sobie z prostymi zadaniami, refaktoryzacją i analizą mniejszych fragmentów kodu. Przy większych projektach, długim kontekście i bardziej złożonej architekturze aplikacji różnice w jakości w porównaniu do Claude Opus czy Sonnet są wyraźnie zauważalne.

Dla kogo to rozwiązanie ma sens

Uruchomienie Claude Code z Ollamą to dobre rozwiązanie dla osób uczących się programowania, testujących nowe pomysły, realizujących mniejsze projekty lub chcących eksperymentować z agentami AI bez kosztów. Sprawdzi się także jako narzędzie pomocnicze obok płatnych modeli.

Podsumowanie

Integracja Ollama z Claude Code pozwala korzystać z agenta kodującego całkowicie za darmo. Choć jakość lokalnych modeli jest niższa niż w przypadku rozwiązań chmurowych, brak kosztów i pełna kontrola nad środowiskiem sprawiają, że jest to opcja warta przetestowania, szczególnie do prostszych zastosowań.